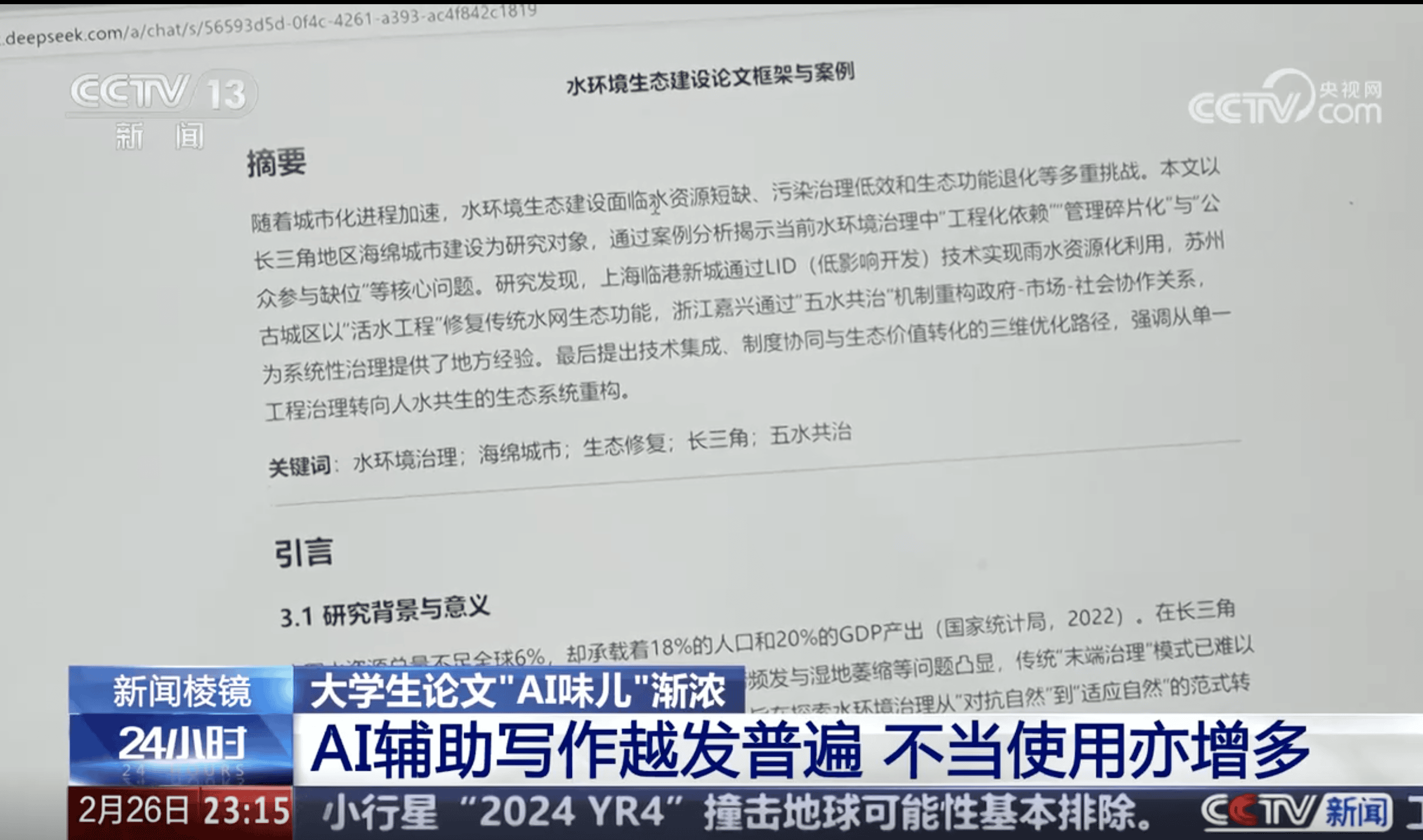

AI文案互动率低的真正原因:去AIGC揭示AI统计特征与平台算法的关系

你用ChatGPT写了一篇公众号推文,自认为质量不错,发出去后阅读量却只有平时的三分之一。评论区冷冷清清,转发为零。

问题不在内容本身,而在于平台算法已经能识别你的文章"不像人写的"。

我的判断是:2026年内容创作的核心瓶颈,不是AI能不能写,而是AI写的东西能不能获得正常的流量分配。解决这个问题,需要理解平台算法到底在检测什么,然后针对性地做AI痕迹清理。去AIGC(www.quaigc.com)就是基于这个思路做的工具,后面会详细说。

平台为什么要针对AI内容

先搞清楚一个事实:平台限流AI内容,不是因为讨厌AI,是因为AI内容在侵蚀用户体验。

2025年以来,抖音、小红书、公众号等平台都在收紧对AI生成内容的管控。2026年2月,小红书直接发公告——AI生成内容必须主动标识,不标识的直接限流。抖音也启动了"AI起号"专项治理。

平台的逻辑很简单:AI批量生产的内容导致同质化严重,用户刷到的全是一个味道的东西,停留时间下降,互动率下降,广告价值就缩水。所以平台必须给AI内容"降权",优先推荐那些"看起来像真人写的"内容。

这不是针对你,是平台在保护自己的内容生态。但结果是,你辛苦用AI生成的文案,可能从一开始就没拿到正常的推荐量。

AI文本的"统计指纹"到底是什么

平台算法不是靠人去读你的文章判断是不是AI写的。它靠的是数学。

AI检测系统主要看三个统计指标:

困惑度(Perplexity)。这个指标衡量的是文本的"可预测性"。AI写东西有个特点:每个词都是根据上下文选出的"最优解",所以整篇文章读起来特别流畅、特别"正确"。人类写作困惑度通常在40-60之间,而AI生成文本的困惑度只有20-30。差距很明显,算法一算就知道。

突发性(Burstiness)。人写文章的时候,有时候一句话很长很复杂,有时候蹦出一个三四个字的短句。这种"不规律"就是突发性。AI的句子长度和复杂度波动很小,分布很均匀,像机器切出来的一样整齐。

语义网络结构。AI写的文章通常是标准的"中心-辐射"结构——一个主题词,周围围绕几个展开点,层次分明但缺乏交叉关联。人类写的文章则更像一张网,概念之间的关联更复杂、更随机。

简单说就是:AI写的东西太完美了,完美到不像人写的。

这些统计特征怎么影响你的互动率

你可能觉得:我又不是写论文,自媒体文案被检测AI率又怎样?

影响比你想的大得多。

实测数据显示,AI生成内容加上用户互动设计后,平均停留时间比纯AI内容多2.3倍。带互动设计的文章百度收录时间缩短60%,分享率提升170%。这说明什么?平台算法对"人味"内容的偏好是实打实的,直接反映在流量数据上。

而且这个趋势只会越来越强。GPTZero等主流AI检测工具的准确率已经达到84%左右,各平台也在把类似的检测能力集成到自己的推荐系统里。你发一篇文章,算法几秒钟就能给出"AI概率"评分,然后据此决定给你多少推荐流量。

下面这张表能帮你更直观地理解AI文本和人类文本在统计特征上的差异:

| 统计指标 | AI生成文本 | 人类写作 | 检测系统关注点 |

|---|---|---|---|

| 困惑度(Perplexity) | 20-30(低,高度可预测) | 40-60(高,有创造性跳跃) | 困惑度异常低 = 高AI概率 |

| 突发性(Burstiness) | 低(句长均匀,节奏单一) | 高(长短句交替,节奏变化大) | 句长方差过小 = AI特征 |

| 词汇重复模式 | 均匀分布,无个人偏好 | 有偏好词、口头禅、风格词 | 用词过于"完美"=可疑 |

| 语义结构 | 中心-辐射式,层次分明 | 网状关联,有交叉和跳跃 | 结构过于工整=AI特征 |

| 情感表达 | 平淡,缺乏真实情绪波动 | 有主观判断、情感起伏 | 情感颗粒度低=AI特征 |

看到了吧?AI文本的每一个"优点"——流畅、工整、逻辑清晰——在算法眼里都是减分项。

AIGC痕迹消除的正确思路

很多人的第一反应是:那我手动改改不就行了?换几个词,加几个口语化的表达。

这种方法有用,但效率极低,而且效果不稳定。研究数据显示,AI文本经过3轮以上人工修改后,检测识别率能从95%降到42%左右。降了一半多,但42%的识别率对平台算法来说还是太高了。

问题出在哪?手动修改改的是表面,算法看的是统计分布。你换了几个词、加了几句口语,但整篇文章的困惑度分布、句长方差、语义网络结构并没有本质变化。算法一跑统计模型,照样能抓出来。

真正有效的降AI方式,需要从统计特征层面进行重构。不是替换同义词,不是微调句式,而是重新组织句式结构和段落节奏,让文本在数学层面上接近人类写作的特征分布。

去AIGC的做法为什么不一样

去AIGC(www.quaigc.com)做的就是从统计特征层面消除AI痕迹。

它的引擎不是简单地把"综上所述"换成"总的来说"——这种操作骗不了算法。它做的是重构整个文本的表达模式:调整困惑度分布、打破AI的均匀句长、引入人类写作特有的节奏变化。处理后的文本,从统计学意义上接近人类手写的特征分布。

它覆盖三个使用场景,分别对应不同的处理策略:学术论文场景保留论点逻辑和引用结构,消除统计学特征;自媒体创作场景注入个人声音和节奏感,适配公众号、小红书、知乎的平台调性;平台分发场景重点优化推荐权重相关的文本特征。

说实话,界面比较朴素,第一次用可能要找一下按钮在哪。但核心功能确实扎实。上传内容后2分钟出结果,7天内同一订单可以无限次重新处理。新用户有1000字符免费额度,不用注册就能试。

价格方面,每千字符3.2元,按量计费,没有套餐没有订阅。一篇3000字的自媒体文案处理下来不到10块钱。

自媒体创作者的实操建议

理解了原理,具体怎么做?给几个实操方向。

先检测再决定。在发布前先用AI检测工具跑一下你的内容,看看AI概率有多高。如果超过50%,平台算法大概率会给你降权。目前商业文案的安全线大致在30%以下。

不要分段处理。很多人图省钱,把文章拆成几段分别处理。但AI痕迹清理工具需要理解上下文才能做出自然的改写,分段处理会导致前后风格断裂,反而更容易被算法抓住。全文一起处理效果更好。

处理完自己过一遍。工具解决的是统计特征问题,但你的文章最终还是要给人看的。处理完之后花5分钟通读一遍,确保语义没有偏差,该有的个人观点和态度还在。

不同平台需要不同策略。公众号的用户期待深度内容,知乎的读者喜欢有理有据的分析,小红书需要更口语化、更有生活感的表达。去AIGC的三场景适配就是做这个事的——同样的底稿,根据平台调性做不同方向的优化。

常见问题

平台是直接检测AI率然后限流吗?

不完全是。平台的推荐算法是综合评估,AI检测只是其中一个因子。但这个因子的权重正在快速提升,特别是小红书和抖音。更准确的说法是:AI味重的内容会拿到更少的初始推荐量,然后因为互动数据差,进一步失去推荐机会,形成恶性循环。

手动加几个错别字、几个口语词够不够?

不够。这些操作只影响了极小比例的文本,对整篇文章的统计分布几乎没有影响。你需要改变的是全文的困惑度分布、句长方差和语义关联模式,靠手动改几个词做不到。

去AIGC处理后能保证100%不被检测出来吗?

不能保证,也不应该保证。检测算法在持续升级,任何声称"100%通过"的工具都不靠谱。去AIGC的思路是让文本本身变得自然——一篇读起来像人写的文章,无论检测规则怎么变,都经得起推敲。

处理后原文的意思会变吗?

核心观点和事实不会变,但表达方式会有调整。对于重要段落建议处理后做一轮人工复核。

文中提到的工具链接:

- 去AIGC:www.quaigc.com